Inteligência Artificial é o assunto do momento. Desde corredores de supermercado até conferências de tecnologia, todo mundo está falando sobre isso.

Se você é como eu, fica frequentemente animado com os avanços da IA. Mas até onde você está disposto a ir para contribuir com isso?

Eu sei que o título deste artigo parece um pouco sensacionalista, mas lamento informar que esta é a realidade.

Não há uma forma gentil de dizer isso: suas postagens públicas compartilhadas nas plataformas da Meta, como Facebook e Instagram, estão sendo usadas para treinar modelos de IA, e você não pode impedi-los.

Por quê? Porque você concordou com isso quando criou sua conta nessas plataformas.

Eu sei, eu também não costumo ler as políticas de privacidade das redes sociais e não sabia até recentemente que a Meta poderia fazer isso.

- Mas que tipo de dados eles estão coletando?

- O que a Meta pode fazer com seus dados?

- Todo mundo está sujeito ao treinamento de IA da Meta?

- E se eu não morar no Reino Unido ou na UE, mas não quiser que a Meta use meus dados?

- Existe uma saída real?

- Você deveria realmente se preocupar com seus dados?

Mas que tipo de dados eles estão coletando?

Não sou apenas eu dizendo isso. No site da Meta, qualquer um pode ler:

“Conforme compartilhamos em setembro, usamos informações disponíveis publicamente online e licenciadas para treinar IA na Meta, assim como as informações que as pessoas compartilharam publicamente nos nossos produtos e serviços. Essas informações incluem postagens ou fotos públicas e suas legendas. No futuro, também podemos usar as informações que as pessoas compartilham ao interagir com nossos recursos de IA generativa, como o Meta AI, ou com alguma empresa, para desenvolver e melhorar nossos produtos de IA.” (Tradução livre)

Agora você me diz se o título é sensacionalista ou apenas uma realidade um tanto quanto desconfortável. Bem, pelo menos eles juram de pés juntos que não leem nossas mensagens privadas.

Mas convenhamos, isso é o mínimo, né?

Medidas de privacidade e controle do usuário

A Meta afirma ter um compromisso com a privacidade e estabeleceu um robusto processo interno de revisão.

Isso inclui avaliar potenciais riscos e implementar medidas para mitigá-los, segundo eles.

Eles operam sob cinco valores principais: privacidade e segurança, justiça e inclusão, robustez e segurança, transparência e controle, e governança e responsabilidade.

Você confia neles?

O que a Meta pode fazer com seus dados?

A Meta usa as informações que você compartilha em suas plataformas para alimentar seus modelos de IA generativa.

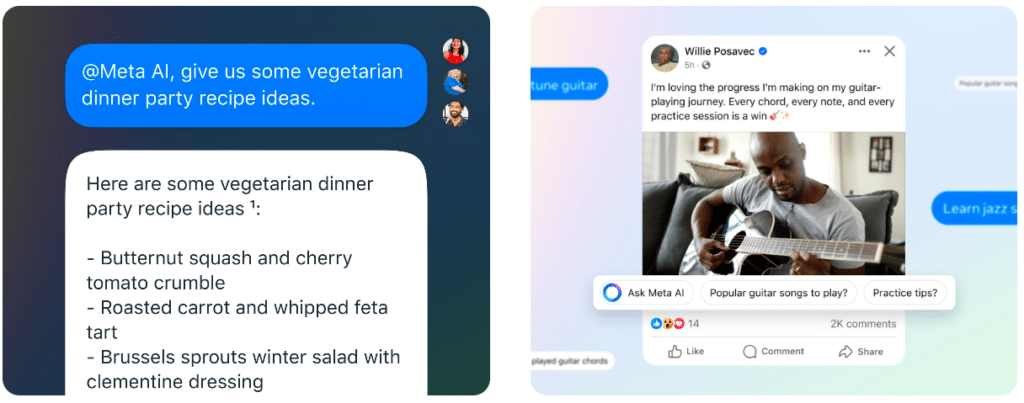

Esses modelos, que incluem ferramentas como o Meta AI e Ferramentas Criativas de IA, são projetados para melhorar a experiência do usuário, resolvendo problemas complexos, fornecendo respostas em tempo real e permitindo a expressão criativa.

O que isso significa?

A Meta usa os dados coletados para ensinar os modelos de IA a entender as relações entre diferentes tipos de conteúdo.

Por exemplo, modelos de texto são treinados para prever padrões de linguagem e gerar respostas conversacionais, enquanto modelos de imagem aprendem a criar novas imagens com base em descrições textuais.

Todo mundo está sujeito ao treinamento de IA da Meta?

Na verdade, nem todo mundo está sujeito a ter suas informações reutilizadas para o treinamento de IA.

Se você vive no Reino Unido, em qualquer um dos estados membros da União Europeia (UE) ou na Área Econômica Europeia (EEA), você se beneficia de leis de proteção de dados mais rigorosas.

Por quê? Empresas fora dessas regiões, mas que processam dados de cidadãos do Reino Unido ou da UE, devem cumprir a Lei de Proteção de Dados do Reino Unido (DPA) e o Regulamento Geral de Proteção de Dados da UE (GDPR).

Então, se você vive no Reino Unido ou na UE, inicialmente, poderia seguir alguns passos no menu “Configurações e Privacidade” para optar por sair do treinamento de IA da Meta.

Agora você nem precisa mais se preocupar, já que a Meta pausou completamente o treinamento de seus modelos de IA na Europa, como consequência do endurecimento das regulamentações europeias.

Essa pausa é um retrocesso para a Inovação Europeia?

Segundo a Meta, sim. A empresa admitiu estar desapontada e definiu a situação como “[…] um retrocesso para a inovação europeia que atrasa ainda mais a entrega dos avanços da IA para as pessoas na Europa.” (tradução livre)

A CNIL discorda! A autoridade francesa de proteção de dados publicou suas primeiras recomendações sobre a aplicação do GDPR ao desenvolvimento da IA.

Segundo a CNIL, trata-se de inovar respeitando os direitos das pessoas — que conceito inovador, não é?

Eles estão confiantes de que, com as diretrizes corretas, podemos ter o melhor dos dois mundos, aproveitando as vantagens da IA sem comprometer a privacidade.

E se eu não morar no Reino Unido ou na UE, mas não quiser que a Meta use meus dados?

Algumas pessoas tem feito postagens nas redes sociais da Meta, dizendo que não permitem que seus dados sejam usados para o treinamento de IA.

Algo do tipo: “Ei, Meta, eu não estou te dando permissão para fazer isso. Pare.” E obviamente, as coisas não funcionam assim.

Como eu disse, nós aceitamos os termos (mesmo sem os ler), e não há como voltar atrás.

Mas sempre há “o caminho menos percorrido” — você pode deletar seu conteúdo publicado ou sua conta inteira e viver como os Incas (risos).

Outra opção é configurar tudo como privado, já que os termos se aplicam apenas a informações públicas. Eu gosto mais dessa opção.

No entanto, embora você possa deletar conteúdo ou tornar contas privadas, é difícil apagar completamente sua pegada digital, especialmente quando outras pessoas podem compartilhar informações sobre você.

Um pequeno truque que você pode tentar

A Meta tem um formulário escondido em seu centro de privacidade chamado “Direitos do titular dos dados para informações de terceiros usadas para IA na Meta”. Você pode preenchê-lo para pedir à Meta que delete qualquer informação pessoal sua usada para treinar IA.

Mas tem um detalhe — a Meta não faz isso automaticamente. Eles revisam os pedidos para ver se são obrigados por leis locais a remover seus dados.

Algumas pessoas, como Alanna Smith, proprietária de uma pequena empresa em Toronto, tentaram esse caminho. Ela teve que provar que seus dados foram realmente usados pela IA da Meta, o que é tipo provar que seu gato não é quem manda na sua casa — quase impossível!

Smith nunca recebeu uma confirmação, então ela está se perguntando se seu pedido realmente foi processado. E quando questionado, o porta-voz da Meta não deu detalhes sobre quantas pessoas conseguiram evitar o uso de seus dados.

Então, boa sorte!

Existe uma saída real?

Depende do que você considera uma saída. Mas, ei, você já ouviu falar do app Cara?

O app Cara é uma nova rede social projetada especificamente para artistas compartilharem seu trabalho sem medo de que ele seja usado para treinar modelos de IA.

Deste modo, o Cara se posiciona como um porto seguro para os criativos.

Ele consegue isso implementando recursos como tags “NoAI” em todas as postagens, sinalizando para os mineradores de dados de IA não usarem o conteúdo.

Embora essas tags possam não ser infalíveis, elas representam um passo significativo na proteção do trabalho dos artistas.

Você deveria realmente se preocupar com seus dados?

Ok, sejamos realistas. Você deveria se preocupar com a Meta usando seus dados para treinar os modelos de IA deles?

Apesar dos valores e medidas de privacidade da Meta, sim, é totalmente compreensível ter algumas preocupações sobre seus dados.

Claro, a Meta oferece recursos de transparência e controle, mas sejamos honestos—a quantidade de dados que eles coletam não é pequena.

A verdadeira preocupação se resume ao equilíbrio entre controle e transparência versus a vasta quantidade de dados que a Meta coleta e usa.

Por um lado, os modelos de IA generativa da Meta prometem recursos super legais e uma melhor experiência do usuário. Mas, por outro lado, isso vem ao custo do uso extensivo de dados pessoais.

E para aqueles (como nós) fora das regiões protegidas, optar por não ter os dados usados para treinamento de IA geralmente não é uma opção.

Então, o que você acha? Vale a pena o uso dos seus dados em troca de recursos incríveis de IA, ou essa ideia faz você repensar seus hábitos nas redes sociais?

CONTEÚDO CRIADO POR HUMANOS

Encontre os melhores freelancers de conteúdo no WriterAccess.

CONTEÚDO CRIADO POR HUMANOS

Encontre os melhores freelancers de conteúdo em WriterAccess.